排序

WordPress国际化的常见问题及解决办法——WordPress

WordPress的使用者遍布全球各个国家,它作为全世界市场占有率最高的CMS系统全球化自然是每一个开发者必须考虑的重点功能。从WordPress 3.7 开始

网站提升SEO编辑robots.txt的正确用法

robots.txt(统一小写)是一种存放于网站根目录下的ASCII编码的文本文件,它通常告诉网络搜索引擎的漫游器(又称网络蜘蛛),此网站中的哪些内容是不应被搜索引擎的漫游器获取的,哪些是可以被...

WordPress网站的Robots文件应该怎么写呢

在建站基础教程中,我们介绍了什么是Robots文件以及它的作用是什么。(感兴趣,可以看下什么是robots协议)。在我们做网站优化过程中,Robots文件是比较重要的文件。对于WordPress建网站,应该...

SEO:真的需要为所有外链加上Nofollow属性吗?

外链加上Nofollow属性意味着告诉搜索引擎”不要追踪此链接”,自从HTML的<a>标签支持该属性后,很多SEO人员或站长到处鼓吹Nofollow的好处,很多网站将所有外链一律加上Nofollow属性。而互...

WordPress利用Robots协议优化站点收录率

Robots协议了解:Robots文件(也称为爬虫协议、机器人协议等),它的全称是“网络爬虫排除标准”(Robots Exclusion Protocol),网站通过 Robots 协议告诉搜索引擎哪些页面可以抓取,哪些页面...

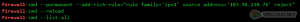

网站怎么屏蔽禁止垃圾蜘蛛爬虫,节省网站资源消耗的优化教程

互联网上有很多的网络爬虫机器人,它们带着各自的任务到处爬行,但这些爬虫机器人有些是有用的,例如Baiduspider、Googlebot、bingbot等。但还有很多垃圾爬虫,对网站没有任何益处,还耗费资源...